3月29日,金融学院在沙河校区图书馆地下报告厅举办中央财经大学2025年专题学术讲座。此次讲座邀请到香港大学协理副校长林晨教授,分享题为《AI Agent and Human Biases》的精彩研究。讲座由中央财经大学校长助理、金融学院院长张学勇教授主持。

讲座伊始,林晨教授简要阐释了本项研究的背景与意义。根据LinkedIn数据,目前美国有37%的机构正在积极整合或计划将生成式人工智能(Gen AI)工具应用于员工招聘,还有31%的机构正在使用生成式人工智能开展相关试验。虽然AI工具被寄望于提升劳动力招聘决策效率,但大语言模型的训练机制可能会传递社会偏见。那么基于AI招聘的社会偏见是否真实存在?AI如何影响企业招聘决策和劳动力市场结果?科学回答上述问题,探究基于AI的劳动者招聘特点,有助于理解并削弱社会不平等,推动社会公平。

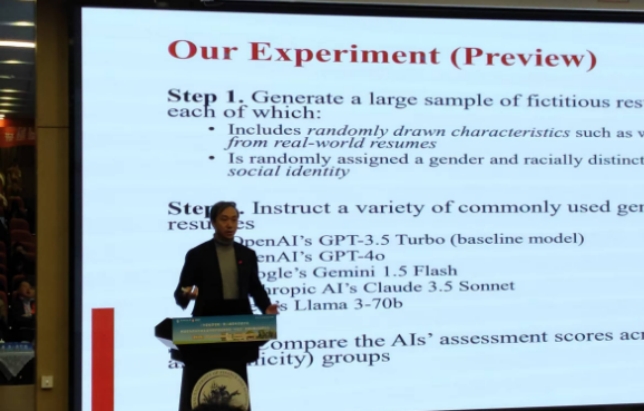

其次,林晨教授详细介绍论文研究方法。研究团队从主流求职网站(Indeed、Snagajob)随机提取初级水平的招聘职位,选取具有代表性的20个职位,对应每个职位随机抓取相同数量的真实简历,通过算法生成36.1万份高度仿真的虚构简历。这些简历在工作经历、教育背景、技能水平等维度都经过严格标准化处理,唯一区别变量是通过具有种族特征的姓名标识申请人的社会身份。研究团队使用OpenAI旗下的GPT-3.5 Turbo(作为基准模型)和GPT-4o,Google旗下的Gemini 1.5 Flash,Anthropic AI旗下的Claude 3.5 Sonnet和Meta旗下的Llama 3-70b五款主流大模型担任“AI面试官”,对每份简历进行百分制评分。

关于研究发现,林晨教授指出:首先,在性别维度上,对于工作经历、教育背景和技能相似的候选人,“AI面试官”给予女性候选人更高评分,但对同等资历的黑人男性候选人评分较低。其次,从研究样本所在州的政治倾向看,研究者根据2020年美国总统选举结果所体现的政治倾向,将研究样本所在的州分为两组,研究显示,AI模型在评估来自民主党州的候选人时更具亲社会性,评分更友好。最后,关于其他种族群体面临的招聘偏见,研究发现亚裔与西班牙裔候选人遭受歧视程度较高,这种偏见在使用不同版本的AI模型评估后均明显存在。

交流互动环节,与会者围绕使用新的AI模型测度、考虑职业特点等问题展开积极讨论。本次活动在与会者的热烈掌声中圆满结束。

撰稿:田诗文、唐宝时 审核:王立勇